Vollständig online und international zugängliche European IT Security Certification Academy aus Brüssel, EU, geleitet vom European Information Technologies Certification Institute - ein Standard zur Bescheinigung digitaler Fähigkeiten im Bereich Cybersicherheit.

Die Hauptaufgabe der EITCA-Akademie besteht darin, den EU-basierten, international anerkannten, formalen Kompetenzzertifizierungsstandard weltweit zu verbreiten, der leicht online zugänglich ist, die europäische und globale Informationsgesellschaft unterstützt und die Lücke bei digitalen Kompetenzen schließt.

Der Standard basiert auf dem umfassenden EITCA/IS Academy-Programm einschließlich 12 relevanten individuellen EITC-Zertifikaten. Die Anmeldegebühren für die EITCA Academy decken die vollen Kosten aller enthaltenen EITC-Programme ab und stellen den Teilnehmern alle entsprechenden EITC-Zertifikate der EITCA Academy sowie ein entsprechendes EITCA Academy-Zertifikat zur Verfügung. Das Programm wird online umgesetzt.Die EITCA/IS Academy-Gebühr beträgt 1100 €, aufgrund des EITCI-Zuschusses kann diese Gebühr jedoch um reduziert werden 80% (dh von 1100 € bis 220 €) für alle Teilnehmer (unabhängig von ihrem Wohnsitzland und ihrer Nationalität) zur Unterstützung der Koalition für digitale Kompetenzen und Arbeitsplätze der Europäischen Kommission.

Die Gebühr der EITCA/IS Academy umfasst die Zertifizierung, ausgewählte Referenzmaterialien und didaktische Beratung.

So funktioniert'sin 3 einfache Schritte

(nachdem Sie Ihre EITCA Academy oder eine ausgewählte Reihe von EITC-Zertifikaten aus dem vollständigen EITCA/EITC-Katalog ausgewählt haben)

REGISTRIEREN SIE SICH BEI DER EITCA/IS ACADEMY +Lernen & üben

Folgen Sie online referenzierten Videomaterialien zur Vorbereitung auf Prüfungen. Es gibt keine festen Kurse, du lernst nach deinem Stundenplan. Keine zeitlichen Begrenzungen. Kompetente Online-Beratung.

Holen Sie sich EITCA-zertifiziert

Nach der Vorbereitung legen Sie die EITC-Prüfungen vollständig online ab. Nach Bestehen aller EITC-Prüfungen erhalten Sie Ihr EITCA Academy-Zertifikat. Unbegrenzte Wiederholungen ohne weitere Gebühren.

Starten Sie Ihre Karriere

Die EITCA/IS Academy-Zertifizierung mit ihren 12 europäischen IT-Zertifikaten (EITC) bescheinigt Ihnen formell Ihre Expertise im Bereich Cybersicherheit. Zertifizieren Sie Ihre beruflichen Fähigkeiten.

Online lernen und üben

Folgen Sie online referenzierten Videomaterialien zur Vorbereitung auf Prüfungen. Es gibt keine festen Kurse, du lernst nach deinem Stundenplan. Keine zeitlichen Begrenzungen. Fachberatung inklusive.

- Die EITCA Academy gruppiert EITC-Programme

- Jedes EITC-Programm ist ca. 15 Stunden lang

- Jedes EITC-Programm definiert einen Umfang der Online-EITC-Prüfung mit unbegrenzten Wiederholungen

- Greifen Sie ohne zeitliche Begrenzung auf die Plattform der EITCA Academy zu, die rund um die Uhr auf didaktische Materialien und Beratungsleistungen verweist

- Sie erhalten auch Zugriff auf die erforderliche Software

Holen Sie sich EITCA-zertifiziert

Nach der Vorbereitung legen Sie Online-EITC-Prüfungen ab (mit unbegrenzten Wiederholungsprüfungen ohne zusätzliche Gebühren) und erhalten Ihre EITCA-Zertifizierung und 12 EITC-Zertifikate.

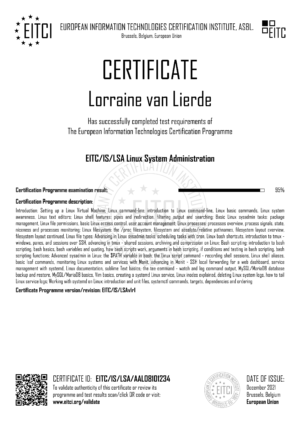

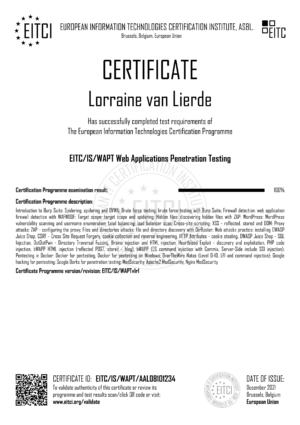

- Zertifikat der EITCA/IS IT Security Academy, das Ihre Expertise im Bereich Cybersicherheit bescheinigt

- Detaillierte Ergänzung zum EITCA/IS-Diplom

- 12 konstituierende EITC-Zertifikate in IS

- Alle in Brüssel nach einem Online-Verfahren ausgestellten und bestätigten Dokumente

- Alle Dokumente werden in digitaler Form mit E-Validierungsdiensten ausgestellt

Starten Sie Ihre Karriere

Das EITCA Academy Zertifikat mit Anhang und die darin enthaltenen EITC Zertifikate bescheinigen Ihre Expertise.

- Nehmen Sie es auf und präsentieren Sie es in Ihrem Lebenslauf

- Präsentieren Sie es Ihrem Auftragnehmer oder Arbeitgeber

- Beweisen Sie Ihren beruflichen Aufstieg

- Zeigen Sie Ihre Aktivitäten in der internationalen Bildung und Selbstentwicklung

- Finden Sie Ihre gewünschte Stelle, lassen Sie sich befördern oder finden Sie neue Verträge

- Treten Sie der EITCI Cloud-Community bei

EITCA/IS INFORMATION SECURITY ACADEMY

Kryptographie - Netzwerksicherheit - Pentesting

- Professionelles europäisches Cybersicherheits-Zertifizierungsprogramm, das remote online mit ausgewählten Referenz-Lernmaterialien von höchster Qualität implementiert wird, die den Lehrplan in einem schrittweisen didaktischen Prozess abdecken

- Umfassendes Programm, einschließlich 12 EITC-Zertifizierungen (ca. 180 Stunden) mit Zugriff auf Software, Expertenberatung, unbegrenzte Prüfungswiederholungen ohne zusätzliche Gebühren, sogar in einem Monat abzuschließen, jedoch ohne zeitliche Begrenzung

- Prüfungs- und Zertifizierungsverfahren werden vollständig online mit EITCA-IT-Sicherheitszertifikaten umgesetzt, die in Brüssel in validierbarer digitaler Form ausgestellt werden und einen permanenten Zugriff auf den Zertifizierungslehrplan und Online-Plattformen bieten

- Völlig eigenständiges Programm, das die Grundlagen abdeckt und auch für Anfänger geeignet ist (Vorkenntnisse im Bereich Cybersicherheit sind nicht erforderlich). Der Schwerpunkt liegt schnell auf praktischen Aspekten der IT-Sicherheit, um berufliche Fähigkeiten in diesem Bereich offiziell nachzuweisen

Alle unten aufgeführten EITC-Zertifizierungsprogramme sind in der EITCA/IS Information Security Academy enthalten

EITCI Institut

Die EITCA Academy besteht aus einer Reihe thematisch verwandter EITC-Zertifizierungsprogramme, die separat absolviert werden können und für sich genommen den Standards für die Bescheinigung professioneller IT-Kenntnisse auf industrieller Ebene entsprechen. Sowohl EITCA- als auch EITC-Zertifizierungen stellen eine wichtige Bestätigung der relevanten IT-Expertise und -Fähigkeiten des Inhabers dar und befähigen Einzelpersonen weltweit, indem sie ihre Kompetenzen zertifizieren und ihre Karriere unterstützen. Der vom EITCI-Institut seit 2008 entwickelte europäische IT-Zertifizierungsstandard zielt darauf ab, die digitale Kompetenz zu fördern, professionelle IT-Kompetenzen für lebenslanges Lernen zu verbreiten und der digitalen Ausgrenzung entgegenzuwirken, indem er Menschen mit Behinderungen sowie Menschen mit niedrigem sozioökonomischem Status und Vor- Jugend der tertiären Schule. Dies steht im Einklang mit den Richtlinien der Digitalen Agenda für Europa, wie sie in ihrem Pfeiler der Förderung von digitaler Kompetenz, Kompetenzen und Inklusion dargelegt sind.

-

EITCA/IS INFORMATION SECURITY ACADEMY

-

€ 1,100.00

- EITCA/IS-Zertifikat & 12 EITC-Zertifikate

- 180 Stunden (kann in 1 Monat abgeschlossen sein)

- Lernen & Prüfungen:Online nach Ihrem Zeitplan

- Konsultationen:Unbegrenzt online

- Prüfungswiederholungen:Unbegrenzt, kostenlos

- Zugang:Sofort mit allen erforderlichen Software-Tests

- 80% EITCI-Zuschuss, keine zeitliche Begrenzung bis zum Abschluss

- Einmalige Gebühr für die EITCA/IS Academy

- 30 Tage volle Geld-zurück-Garantie

-

Einzelnes EITC-Zertifikat

-

€ 110.00

- Einfach ausgewähltes EITC-Zertifikat

- 15 Stunden (kann in 2 Tagen abgeschlossen sein)

- Lernen & Prüfungen:Online nach Ihrem Zeitplan

- Konsultationen:Unbegrenzt online

- Prüfungswiederholungen:Unbegrenzt, kostenlos

- Zugang:Sofort mit allen erforderlichen Software-Tests

- Keine EITCI-Subvention, keine zeitliche Begrenzung

- Einmalige Gebühr für ausgewählte EITC-Zertifizierung (en)

- 30 Tage volle Geld-zurück-Garantie

LORENZO

CHLOE

PETER

1000+

100+

1 000 000 +

50 000 000 +

50 000 +

EITCI-FÖRDERUNGSCODE AN IHRE E-MAIL SENDEN

Der EITCI DSJC-Subventionscode erlässt 80 % der Gebühren für EITCA Academy-Zertifizierungen innerhalb einer begrenzten Anzahl von Plätzen. Der Subventionscode wurde automatisch auf Ihre Sitzung angewendet und Sie können mit der Bestellung Ihrer gewählten EITCA Academy-Zertifizierung fortfahren. Wenn Sie den Code jedoch lieber nicht verlieren und für eine spätere Verwendung (vor Ablauf der Frist) speichern möchten, können Sie ihn an Ihre E-Mail-Adresse senden. Bitte beachten Sie, dass der EITCI DSJC-Zuschuss nur innerhalb seines Förderzeitraums gültig ist, d. h bis zum Ende von 22/4/2024. Die von EITCI DSJC subventionierten Plätze für Zertifizierungsprogramme der EITCA Academy gelten für alle Teilnehmer weltweit. Erfahren Sie mehr auf der EITCI DSJC-Versprechen.